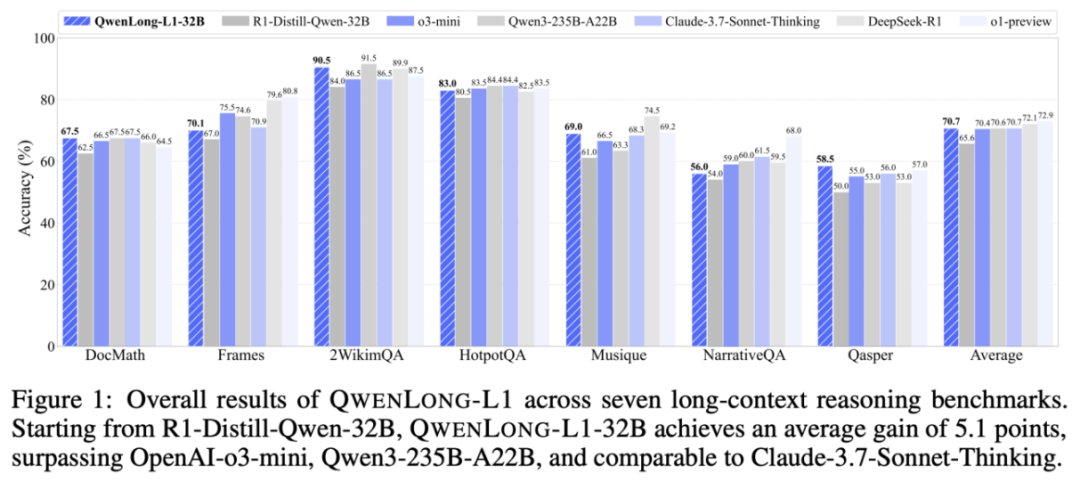

上下文的持续时间高达130,000个令牌,这使得它适用于复杂领域,例如对多隔离文档,法律,法律和科学研究的积分分析。最近的推论模型(LRM)通过增强学习(RL)表现出强大的推论能力,但是这些改进主要反映在短上下文推理任务中。相反,通过增强学习手柄扩展LRM的方法,并在长篇小说中感染输入,同时保持不解决。阿里巴巴·汤伊(Alibaba Tongyi)实验室团队将正式定义长期竞赛的推理增强学习范式,并确定两个核心挑战。培训效率和不稳定的优化过程。为了应对这些问题,团队提出了Qwenlong-L1会议的长期学习加强框架,从而通过上下文扩展策略逐渐在长上下文推理任务中改善了模型的表现。最后,QwenlONG-L1-32B不仅超过了旗舰模型,例如Operai-O3-Mini和Qwen3-235b-A22b,而且在多个长期文档的问题和Claude-3.7-Sonnet-Sonnet-SninkInkinkinkinkinkinkinkinkinkink的响应点和参考响应方面也出人意料地效果很好。主要贡献1。长篇小说推理的加固学习范式的定义与简短句子推断的强化学习不同。强化学习促进了内部知识推断的使用。长篇小说推理的强化学习要求第一个模型找到外部关键信息,然后整合内部推断。 2。确定长期竞争中的关键学习加强问题。在长篇小说中,REFUE学习训练rzo rzo效率低下,这是(a)缓慢奖励的收敛性和(b)模型退出熵的显着降低,这限制了优化过程中的勘探行为。一个在同一时间,对长上下文推断进行的增强学习训练是不稳定的,这被揭示为(c)更具不同的KL峰。 3。QWENLONG-L1学习学习范围的Qwenlong-L1学习框架推理强化是基于渐进式上下文扩展技术和混合奖励机制。 Qwenlong-l1通过强化学习实现了稳定的短篇文本的稳定背景。 4。QWENLON-L1-32B开源上下文文档推理模型与长期前景上下文推理模型相比,Qwenlong-L1-32B取得了显着改善的性能,与DeepSeek-R1-Distill-distill-Qwen-32b相比,平均增加了7.8%。不仅超过了诸如OpenAI-O3-Mini和Qwen3-235b-A22b之类的旗舰模型,而且还比较了Claude-3.7-Sonnet思维的性能,提供了基本的技术解决方案来优化长文本推断。中央技术基于学习强化学习框架传统l短上下文。 Qwenlong-L1主要提出以下改进:奖励机制与渐进式上下文扩展技术和杂交相结合。渐进式上下文扩展技术训练长尺度长尺度模型上下文推断具有动态不稳定优化属性。为了解决这些问题,我们提出了一个渐进式上下文扩展框架,其中包括:课程由课程引起的步骤 - 逐步加强学习策略,以稳定优化短到长上下文的优化过程。采样机构的评论确认了优先考虑复杂实例的难度。此外,在加强学习训练之前,稳定的精细调整预热阶段在加强学习训练之前提供了坚实的初始化基础。预热的精细调整可靠的监视:使用长 - 胸下推理数据在改进之前监督模型的调整,获得稳定的初始策略并减少不稳定性培训。使用课程指南的强化学习步骤:增强学习培训训练扩展到I阶段I和II阶段60K的20K输入长度,逐渐适应更长的上下文。仅在每个阶段训练具有当前长度间隔的样本,以避免混合长度引起的优化冲突。难度识别的回顾性抽样:基于“平均奖励的难度动态计算”样本,首先观察到后续阶段的奖励低(高难度)样本。即将成为。在第二阶段的训练中,含有I期的高分辨率样本被迫不断研究复杂的病例。简短的持续推理任务(例如数学,编程和逻辑推理)中的混合奖励机制通常使用基于规则的奖励功能。但是,开放式领域的问题和答案以及其他上下文推理任务对他们的答案固有的多样性提出了自己的挑战。在这种情况下基于过于限制规则的奖励机制可以限制有效响应的多样性并影响一般绩效。考虑到这些局限性,我们提出了一种混合奖励机制,该机制通过评估互补性来整合规则的验证以及模型和精度和记忆的均衡。规则奖励:从正则表达式模型的输出中删除答案,并严格匹配标准响应。验证您的答案的正确格式,并避免奖励盗版。模型评估:培训过程使用指令QWEN2.5-1.5B作为轻型试验模型,以评估预测和标准响应的语义等效性。组合策略:最终奖励是模型的最大规则和判断,考虑到答案的精确性和多样性。与SFT相比,该实验显示RL性能有显着改善。我们发现只需要1.6k样品为了改善R1 Distill-QWEN模型之后的RL,模型14B的平均增加为4.1,对于32B模型,平均增加了5.1。 Leaderi AM在国家和国际旗舰模型中:Qwenlong-L1-14B @1型号的平均路线达到68.3,Gemini-2.0-Flash-thinking,R1-Distill-Qwen-32b,Qwen3-32b;平均QWENLONG-L1-32B @1模型达到70.7,超过QWQ-PLU S,QWEN3-PLUS,OPERAI-O3-MINI与Chancro Claude-3.7-Sonnet相同。测试时间量表具有明显的性能。 Qwenlong-L1-14B模型的平均路线 @2达到73.7,DeepSeek-R1(通过 @1,72.1),OpenAI-O1-Presto比编辑器(通过 @1,72.9)好。 SFT和RL之间的补偿是研究不同的RL初始模型后的结果。 RL:基本模型,短上下文SFT模型(= 20K),长上下文SFT模型(= 60k)。有趣的发现:SFT和RL扮演互补的角色,SFT的可接受性能成本低,RL对于获得最佳结果很重要。要成就E最佳性能,RL必须优先于SFT,因为对SFTS的注意力将使该模型局部并限制RL的改进。在训练长期推断推理行为期间的表现和推理模式的变化:包括与与推理有关的推理相关的长期会议和与推理有关的推理相关的一般挫折的基础,与推理相关的推理有关,与推理相关的推论有关。有趣的发现:所有模型均显示清晰的推理模式,其较长的基础与大多数频率上下文有关。当然,这些推论模式出现越来越频繁,最终的性能会增加。 SFT推断模式远高于RL,但是将转换性能改善与RL进行了比较。有限的结论这一结论通过强化学习研究了长期会议的推论模型的发展g。首先,我们提出了一个延长上下文推断的强化学习范式,并发现了重要问题,例如次优训练效率和不稳定的优化过程。为了应对这些挑战,研究团队启动了Qwenlong-L1,这是一个具有扩展背景的强化学习框架。实验结果表明,Qwenlong-L1在最长的行业会议模型中效果很好。其中,Qwenlong-L1-14B的性能超过了Gemini-2.0-Flash和Qwen3-32b,而Qwenlong-L1-32B超过了Openai-O3-Mini,QWEN3-235B-A22B,甚至达到了相同的水平。我们的分析揭示了关于学习持续推理的三个重要想法。 Barateel渐进式环境扩展和实现定义适应的重要作用,需要学会优化优先考虑强化强化的绩效以及增加长期文本推理在增强中的作用水泥学习培训以促进绩效改善。

上下文的持续时间高达130,000个令牌,这使得它适用于复杂领域,例如对多隔离文档,法律,法律和科学研究的积分分析。最近的推论模型(LRM)通过增强学习(RL)表现出强大的推论能力,但是这些改进主要反映在短上下文推理任务中。相反,通过增强学习手柄扩展LRM的方法,并在长篇小说中感染输入,同时保持不解决。阿里巴巴·汤伊(Alibaba Tongyi)实验室团队将正式定义长期竞赛的推理增强学习范式,并确定两个核心挑战。培训效率和不稳定的优化过程。为了应对这些问题,团队提出了Qwenlong-L1会议的长期学习加强框架,从而通过上下文扩展策略逐渐在长上下文推理任务中改善了模型的表现。最后,QwenlONG-L1-32B不仅超过了旗舰模型,例如Operai-O3-Mini和Qwen3-235b-A22b,而且在多个长期文档的问题和Claude-3.7-Sonnet-Sonnet-SninkInkinkinkinkinkinkinkinkinkink的响应点和参考响应方面也出人意料地效果很好。主要贡献1。长篇小说推理的加固学习范式的定义与简短句子推断的强化学习不同。强化学习促进了内部知识推断的使用。长篇小说推理的强化学习要求第一个模型找到外部关键信息,然后整合内部推断。 2。确定长期竞争中的关键学习加强问题。在长篇小说中,REFUE学习训练rzo rzo效率低下,这是(a)缓慢奖励的收敛性和(b)模型退出熵的显着降低,这限制了优化过程中的勘探行为。一个在同一时间,对长上下文推断进行的增强学习训练是不稳定的,这被揭示为(c)更具不同的KL峰。 3。QWENLONG-L1学习学习范围的Qwenlong-L1学习框架推理强化是基于渐进式上下文扩展技术和混合奖励机制。 Qwenlong-l1通过强化学习实现了稳定的短篇文本的稳定背景。 4。QWENLON-L1-32B开源上下文文档推理模型与长期前景上下文推理模型相比,Qwenlong-L1-32B取得了显着改善的性能,与DeepSeek-R1-Distill-distill-Qwen-32b相比,平均增加了7.8%。不仅超过了诸如OpenAI-O3-Mini和Qwen3-235b-A22b之类的旗舰模型,而且还比较了Claude-3.7-Sonnet思维的性能,提供了基本的技术解决方案来优化长文本推断。中央技术基于学习强化学习框架传统l短上下文。 Qwenlong-L1主要提出以下改进:奖励机制与渐进式上下文扩展技术和杂交相结合。渐进式上下文扩展技术训练长尺度长尺度模型上下文推断具有动态不稳定优化属性。为了解决这些问题,我们提出了一个渐进式上下文扩展框架,其中包括:课程由课程引起的步骤 - 逐步加强学习策略,以稳定优化短到长上下文的优化过程。采样机构的评论确认了优先考虑复杂实例的难度。此外,在加强学习训练之前,稳定的精细调整预热阶段在加强学习训练之前提供了坚实的初始化基础。预热的精细调整可靠的监视:使用长 - 胸下推理数据在改进之前监督模型的调整,获得稳定的初始策略并减少不稳定性培训。使用课程指南的强化学习步骤:增强学习培训训练扩展到I阶段I和II阶段60K的20K输入长度,逐渐适应更长的上下文。仅在每个阶段训练具有当前长度间隔的样本,以避免混合长度引起的优化冲突。难度识别的回顾性抽样:基于“平均奖励的难度动态计算”样本,首先观察到后续阶段的奖励低(高难度)样本。即将成为。在第二阶段的训练中,含有I期的高分辨率样本被迫不断研究复杂的病例。简短的持续推理任务(例如数学,编程和逻辑推理)中的混合奖励机制通常使用基于规则的奖励功能。但是,开放式领域的问题和答案以及其他上下文推理任务对他们的答案固有的多样性提出了自己的挑战。在这种情况下基于过于限制规则的奖励机制可以限制有效响应的多样性并影响一般绩效。考虑到这些局限性,我们提出了一种混合奖励机制,该机制通过评估互补性来整合规则的验证以及模型和精度和记忆的均衡。规则奖励:从正则表达式模型的输出中删除答案,并严格匹配标准响应。验证您的答案的正确格式,并避免奖励盗版。模型评估:培训过程使用指令QWEN2.5-1.5B作为轻型试验模型,以评估预测和标准响应的语义等效性。组合策略:最终奖励是模型的最大规则和判断,考虑到答案的精确性和多样性。与SFT相比,该实验显示RL性能有显着改善。我们发现只需要1.6k样品为了改善R1 Distill-QWEN模型之后的RL,模型14B的平均增加为4.1,对于32B模型,平均增加了5.1。 Leaderi AM在国家和国际旗舰模型中:Qwenlong-L1-14B @1型号的平均路线达到68.3,Gemini-2.0-Flash-thinking,R1-Distill-Qwen-32b,Qwen3-32b;平均QWENLONG-L1-32B @1模型达到70.7,超过QWQ-PLU S,QWEN3-PLUS,OPERAI-O3-MINI与Chancro Claude-3.7-Sonnet相同。测试时间量表具有明显的性能。 Qwenlong-L1-14B模型的平均路线 @2达到73.7,DeepSeek-R1(通过 @1,72.1),OpenAI-O1-Presto比编辑器(通过 @1,72.9)好。 SFT和RL之间的补偿是研究不同的RL初始模型后的结果。 RL:基本模型,短上下文SFT模型(= 20K),长上下文SFT模型(= 60k)。有趣的发现:SFT和RL扮演互补的角色,SFT的可接受性能成本低,RL对于获得最佳结果很重要。要成就E最佳性能,RL必须优先于SFT,因为对SFTS的注意力将使该模型局部并限制RL的改进。在训练长期推断推理行为期间的表现和推理模式的变化:包括与与推理有关的推理相关的长期会议和与推理有关的推理相关的一般挫折的基础,与推理相关的推理有关,与推理相关的推论有关。有趣的发现:所有模型均显示清晰的推理模式,其较长的基础与大多数频率上下文有关。当然,这些推论模式出现越来越频繁,最终的性能会增加。 SFT推断模式远高于RL,但是将转换性能改善与RL进行了比较。有限的结论这一结论通过强化学习研究了长期会议的推论模型的发展g。首先,我们提出了一个延长上下文推断的强化学习范式,并发现了重要问题,例如次优训练效率和不稳定的优化过程。为了应对这些挑战,研究团队启动了Qwenlong-L1,这是一个具有扩展背景的强化学习框架。实验结果表明,Qwenlong-L1在最长的行业会议模型中效果很好。其中,Qwenlong-L1-14B的性能超过了Gemini-2.0-Flash和Qwen3-32b,而Qwenlong-L1-32B超过了Openai-O3-Mini,QWEN3-235B-A22B,甚至达到了相同的水平。我们的分析揭示了关于学习持续推理的三个重要想法。 Barateel渐进式环境扩展和实现定义适应的重要作用,需要学会优化优先考虑强化强化的绩效以及增加长期文本推理在增强中的作用水泥学习培训以促进绩效改善。